AI관련해서 작년만 해도 변화가 그렇게 크지 않다고 느꼈었는데, MCP 나 나오면 표준화 작업과 멀티 모달을 지원하는 AI들이 나오며 붐이 오고 있습니다.

문제는 수익창출입니다.

작은 회사와 적은 인원의 팀에는 무료 또는 일반인에게 무료로 하고 기업에는 유료 등 다양한 정책들이 나오고 있습니다.

현시점에서 과연 수익을 낼 수 있는 AI 기업은 얼마나 있을까요?

국가 경쟁력을 위해 투자를 한다고 했는데 어떤 부분에 지원이 들어올까요?

이런 상황에 AI 월 구독 서비스를 이용하는 방법의 대안이 되는 것은 로컬 머신을 사용한 AI 활용이라 생각해서 설정해 보게 되었습니다.

표준 API가 적용되는 AI가 나오고 오픈 소스 시장에도 곧 AI 대세변화가 다시 올꺼라 생각합니다.

제가 생각하는 AI 쪽에도 비트 코인 식으로 분산 시스템을 사용하는 AI가 조만간 나올것이라 생각합니다. 자비스 였던가요? 비트코인과 같이 자금이 되는 것을 AI에 연결되는 시기에 기존에 하던 사람들만 계속 앞으로 갈 수 있는 분위기가 올것입니다.

자 사설을 여기까지 하고 설정해 봅시다.

VSCode -- Ollama - llama3, Deepseek

- 확장프로그램 검토 "Continue"1. VSCode 용 확장 프로그램 목록

| 확장명 | 장점 | 단점 |

| Continue (by Continue.dev) | Ollama 직접 연동 가능 / 빠른 반응 / Lightweight | 일부 기능은 VSCode에 제한적 |

| CodeGPT (by Daniel San) | API URL 커스터마이징(Ollama 호환 가능) | 사용 전에 수동 설정 필요 |

| ChatGPT - Code Companion | UI 친화적 / 명령어 프롬프트 탭 | 기본은 OpenAI API (Ollama 설정 복잡) |

| Continue + Ollama 서버 | 로컬 LLM + 실시간 코드 추천 | 모델에 따라 응답 정확도 차이 |

2025.05.27 - [프로그램/docker] - vibe coding 를 위한 deepseek in On-Premise(2025.05.26)

vibe coding 를 위한 deepseek in On-Premise(2025.05.26)

AI 홍보하시는 분들은 AI를 이용해서 코딩을 모두 할 수 있을 것처럼 이야기하지만 내용을 아는 사람이 일을 시키고 확인이 되어야 하듯 시니어 개발자에게 좀더 좋은 환경이 열리는 느낌이네요.

jsi0.tistory.com

2. VSCode에서 Ollama 연결 및 사용 방법 (Continue 기준)

① 확장 설치 : VSCode 확장프로그램 검색 및 설치

② Ollama 로컬 서버 실행 확인 : 설치된 모델 목록을 확인

>curl http://localhost:11434/api/tags

{

"models": [

{

"name": "llama3.2:latest",

"model": "llama3.2:latest",

"modified_at": "2025-05-27T06:05:27.101772814Z",

"size": 2019393189,

"digest": "a80c4f17acd55265feec403c7aef86be0c25983ab279d83f3bcd3abbcb5b8b72",

"details": {

"parent_model": "",

"format": "gguf",

"family": "llama",

"families": [

"llama"

],

"parameter_size": "3.2B",

"quantization_level": "Q4_K_M"

}

},

{

"name": "deepseek-r1:7b",

"model": "deepseek-r1:7b",

"modified_at": "2025-05-26T15:38:46.360976443Z",

"size": 4683075271,

"digest": "0a8c266910232fd3291e71e5ba1e058cc5af9d411192cf88b6d30e92b6e73163",

"details": {

"parent_model": "",

"format": "gguf",

"family": "qwen2",

"families": [

"qwen2"

],

"parameter_size": "7.6B",

"quantization_level": "Q4_K_M"

}

}

]

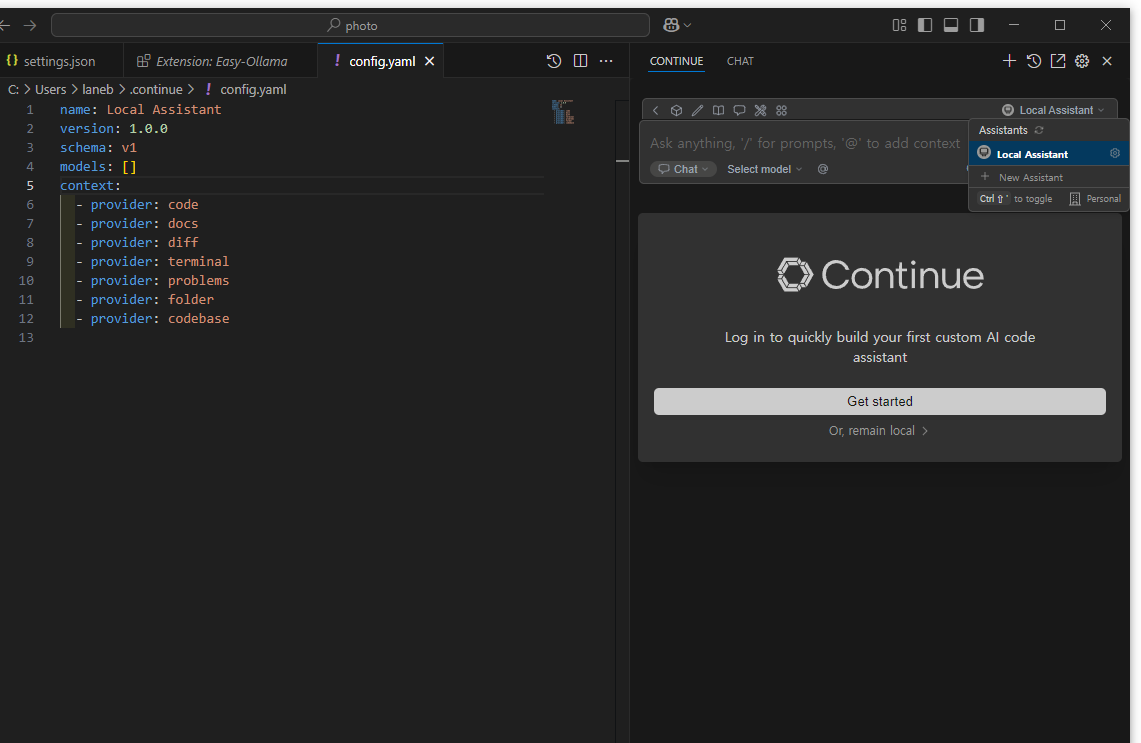

}③ VSCode 설정

- Continue: 확장 아이콘이 있는 경우 드레그해서 오른쪽에 사이바에 붙이기

or View ->apprence->secondary side bar,

continue local assistant -> local Assistant 톱니 클릭

# .continue>config.yaml

name: Local Assistant

version: 1.0.0

schema: v1

models: []

context:

- provider: code

- provider: docs

- provider: diff

- provider: terminal

- provider: problems

- provider: folder

- provider: codebase로컬 설정 내용 반영

name: Local Assistant

version: 1.0.0

schema: v1

models: [

{

name: llama3,

provider: ollama,

model: llama3,

apiBase: http://localhost:11434,

roles: [chat, edit, apply, summarize]

},

{

name: deepseek-r1:7b,

provider: ollama,

model: deepseek-r1:7b,

apiBase: http://localhost:11434,

roles: [autocomplete]

}

]

context:

- provider: code

- provider: docs

- provider: diff

- provider: terminal

- provider: problems

- provider: folder

- provider: codebase

참고로 버전에 따라 설정 방법이 바뀐것 같습니다.

LLM 설정하는 것이 전에 있었던거 같은데 yaml 파일 설정에서 모델 설정하는 것으로 바뀌었나보네요.

참고 바랍니다.

일단 연결까지 설정했습니다.

샘플 프로젝트 만들어서 테스트 해보고 마져 정리해 보겠습니다.

'AI와 교육 > AI Literacy' 카테고리의 다른 글

| 이미지 생성 AI 조사 (2025.06.04) (3) | 2025.06.04 |

|---|---|

| n8n을 이용한 telegram 메시지처리(2025.06.03) (1) | 2025.06.03 |

| 기계학습 개발 환경 (1) | 2024.07.10 |

| 용어 정리_yolo학습시작부터(2024.07.05~ 진행중) (0) | 2024.07.05 |

| YOLOv8 ->YOLOv10(2024.07.05~7/15진행중) (1) | 2024.07.05 |